En ambientes de tecnología hablar de Alta Disponibilidad es un tema del día a día, especialmente si estamos considerando la infraestructura donde se ejecutan las plataformas críticas.

PLATAFORMA CRITICA = Sistema que del cual depende el ingreso de la compañía o que una falla sobre el mismo puede afectar la reputación de la empresa.

Es por eso que de forma general encontramos escenarios de CLUSTER o ALTA DISPONIBILIDAD que están diseñados bajo una Arquitectura Tradicional, en donde “tradicional” no quiere decir antiguo, mas bien un esquema compuesto por tres componentes:

a) Servidores

b) Conectividad (Switches de red)

c) Almacenamiento

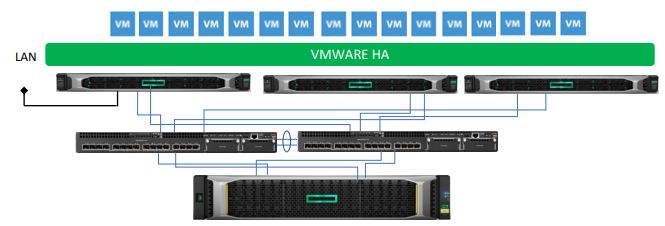

Un diagrama conceptual de cómo luce una arquitectura tradicional sería el siguiente:

En esta imagen tenemos un CLUSTER DE SERVIDORES VIRTUALES, en donde cada servidor (Hypervisor) actúa de forma tal que si uno de ellos falla, los servidores virtuales son “migrados” hacia cualquiera otro Hypervisor que forme parte del cluster (siempre y cuando tengan suficientes recursos de CPU/RAM).

En este escenario, debes de administrar los siguientes componentes:

- a) Plataforma de Virtualización

- b) Equipos de comunicación

- c) Sistema de Almacenamiento

Con el sistema de almacenamiento, para estos escenarios particularmente entre las actividades administrativas a realizar están la de crear los discos virtuales (LUN), manejo de los niveles de protección de datos (RAID), si hay otro almacenamiento los aspectos de replicación y otras cosas muy específicas a este tipo de soluciones. El desempeño del almacenamiento dependerá de varios aspectos, por lo que es importante haber realizado un correcto dimensionamiento o análisis según las cargas de trabajo.

¿Cuál es la diferencia respecto a la Hyperconvergencia?

La diferencia fundamental en la Hyperconvergencia es que se Virtualiza el Almacenamiento, esto indica lo siguiente

- El hardware como tal del almacenamiento desaparece.

- El almacenamiento se distribuye a lo largo de los discos internos de cada servidor que forma parte de la Hyperconvergencia.

- Cada servidor debe de poseer al menos 1 discos SSD para funciones de cache y discos adicionales para generar la capacidad del almacenamiento.

Esto quiere decir que hoy los servidores deben de ser configurados con discos de tal forma que se puede armar una Solución HYBRIDA (Discos HDD + SSD)

O en configuración ALL FLASH en donde todos los discos del servidor son de estado sólido:

Cuando ya tienes los servidores listos bajo cualquiera de estas configuraciones, solo necesitas seleccionar la solución de software que estará manejando la Hyperconvergencia entre los cuales están:

Claro que existe un líder en el mercado, los últimos cuadrantes de Gartner reflejan que NUTANIX junto con VMWare se encuentran en el cuadránte de líderes, sin embargo, la solución de Microsoft con su solución de Storage Space Direct es muy interesante y sobre todo porque es un servicio en Windows Server por el cuál no hay necesidad de pagar una licencia adicional.

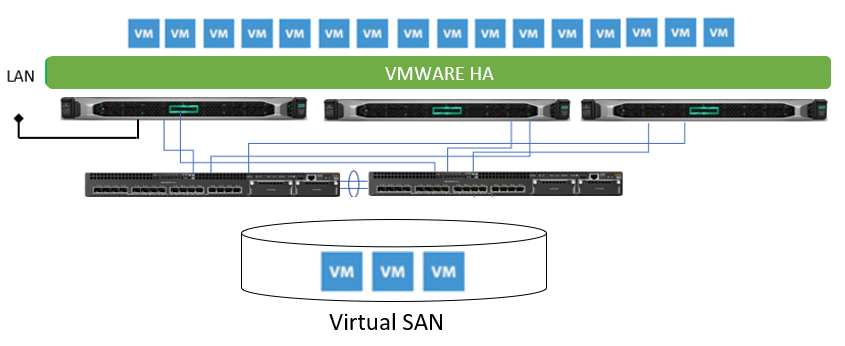

Al final la solución Hyperconvergente luce de la siguiente forma:

Todos los servidores tendrán acceso a un almacenamiento común, en este caso formado por cada uno de los discos internos de cada servidor

Beneficios de la solución Hyperconvergente

Uno de los grandes beneficios de este tipo de soluciones es que todo se administra desde un solo lugar, la plataforma de virtualización..! lo cual facilita a automatización de muchas cosas como por ejemplo, el brindar a través del uso de políticas más capacidad de almacenamiento a servidores virtuales que lo requieran.

¡Mayor desempeño! los datos ahora se encuentran almacenados localmente en cada servidor, esto acelera grandemente el acceso a los datos.

¡Rapido de implementar! Basta con que ya cuentes con los servidores y tu conectividad a 10Gb (requerido) y en pocas horas tienes listo tu escenario de Hyperconvergencia, justo en este sentido NUTANIX literalmente hace magia ya que adicionar nodos a una solución existente, se hace desde un asistente que lo hace en automático, sin afectar nada de lo que esté en operación.

Elasticidad Vertical y Horizontal, en esta solución puede crecer verticalmente cada nodo agregando más memoria o discos internos o de forma horizontal agregando mas nodos a la solución, en ambos casos toda la solución Hyperconvergente aumenta sus capacidades de operación. Algunas soluciones ofrecen crecimiento en cómputo (Procesamiento) o almacenamiento de forma exclusiva para efecto de no tener que realizar un aumento a todos los nodos.

Funciones adicionales integradas como por ejemplo el uso de operaciones de NAS (compartir espacio a usuarios finales), Compresión + Deduplicación se incluyen en algunos casos con licenciamiento adicional.

Preguntas Frecuentes

¿Qué pasa si un servidor falla? — No habría problema, ya que la solución funciona bajo un esquema N+1, es decir, siempre habrá uno servidor que se pueda perder.

¿Qué pasa si se daña un disco de capacidad o cache? — Si consideramos la pérdida de 1 disco, no habría problema, la solución Hyperconvergente almacena copias de los datos de forma distribuida usando esquemas como RAID 1, RAID 5 o RAID 6 en dependencia de la cantidad de servidores que formen la solución.

¿Con cuántos servidores es lo mínimo para armar una solución Hyperconvergente? — 3 es lo mínimo para crear este tipo de soluciones, sin embargo, vale la pena mensionar que HPE posee una solución Hyperconvergente basada en hardware llamada Simplivity que puede operar con 2 nodos.

¿Este tipo de soluciones se pueden integrar a la nube? — Si, en algunos casos se requiere de algún componente adicional y en otros la integración es nativa, dependerá de la solución implementada, en NUTANIX por ejemplo, desde la misma consola de administración central PRISMA se pueden administrar las cargas locales como de nube.